Die Zukunft der emotionalen Intelligenz von Maschinen

von Dr. Michael Bartl

Als Anwendungsbeispiele für KI werden häufig Chatbots für die Kundenkommunikation genannt, auch automatisierte Werbeanzeigen, vorausschauende Wartung von Maschinen, Lager- und Wegoptimierung, Diagnosesysteme in der Medizin oder selbstfahrende Autos.

Dabei geht es im Wesentlichen um die Verbesserungen von Maschinen oder Prozessen durch Autonomisierung und selbstlernende Systeme zur Maximierung von Effizienz. Der nächste Entwicklungspfad wird die Berücksichtigung des Faktors Mensch und seiner Gefühle oder Stimmungen sein: In diesem Zusammenhang wird auch von emotionaler Intelligenz gesprochen, die dem wissenschaftlichen Feld des sogenannten Affective Computing zuzuordnen ist. Dieser interdisziplinäre Ansatz von Computerwissenschaften und Psychologie beschäftigt sich mit Systemen, die Gefühle erkennen und interpretieren. So sollen Maschinen, Roboter und digitale Systeme befähigt werden, auf Emotionen des Anwenders zu reagieren.

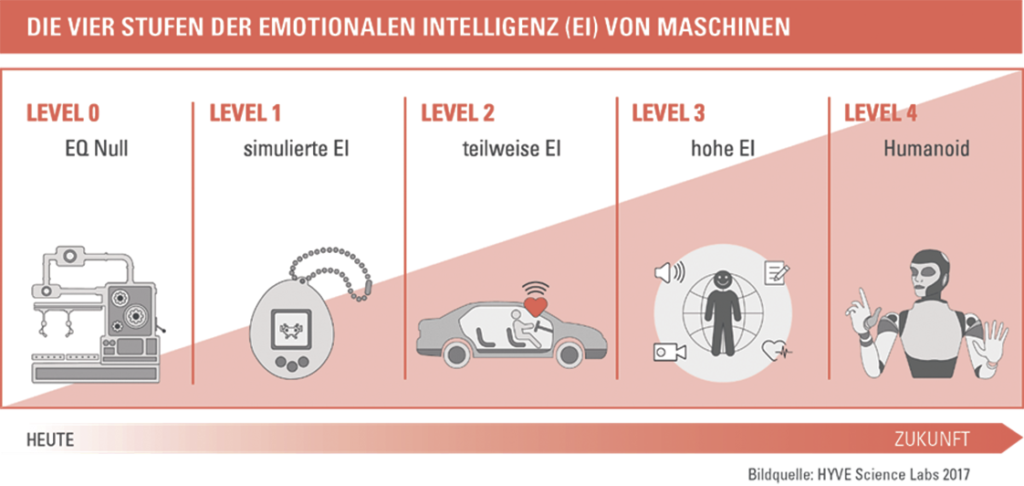

Die vier Stufen der emotionalen Intelligenz von Maschinen

Emotionale Intelligenz oder der Emotionsquotient von Dingen kann in vier Levels klassifiziert werden. Der Level 0 steht für einen EQ von null. Im Moment trifft dieses Level wohl auf nahezu alle Maschinen auf dieser Welt zu. Eine Industrieanlage oder auch ein Taschenrechner haben keinerlei Zugang zu dem affektiven Zustand ihrer Nutzer. Sie dienen dem Menschen lediglich als Werkzeug und Erleichterung, um Aufgaben, wie z. B. kompliziertes Kopfrechnen, zu erledigen. Auch sogenannte „smarte Chatbots“ gehören diesem Level an. Fragen Sie Alexa gerne einmal „Alexa, wie fühle ich mich?“, die Antwort wird Sie enttäuschen.

„Es gibt Dinge, die der Mensch besser kann, und Dinge, die eine Maschine besser kann. In Ergänzung entsteht ein unheimlicher Mehrwert und die Empathie der Maschinen baut eine neue Brücke hierfür.“

Simulierte EI (Level 1) ist in regelbasierten Assistenzen zu finden, die an Emotionen appellieren oder Annahmen zur Stimmungslage treffen, etwa, wenn ein Mensch gestresst wirkt. So signalisiert seit 2009 eine kleine Tasse im Auto-Cockpit in Abhängigkeit der gefahrenen Kilometer die Notwendigkeit einer Pause. Fahrer könnten nach der Strecke müde und unaufmerksam sein. Weiteres Beispiel ist die in den 90er-Jahren aus Japan stammende Erfolgsgeschichte des Tamagotchi. Ein elektronisches Küken, das in Abhängigkeit der Zuwendung bzw. Nutzungsintensität zufrieden ist oder stirbt, um daraufhin wiederbelebt werden zu können. Der Begriff „Tamagotchi-Effekt“ wird im Zusammenhang mit der Entwicklung gegenseitiger emotionaler Bindung zwischen Maschinen und Robotern verwendet.

Von einer echten emotionalen Intelligenz kann man allerdings erst ab Level 2 sprechen. Videodaten von Gesichtern, Audiodaten der Stimme oder biometrische Daten wie Herzschlag und Hautwiderstand werden genutzt, um menschliche emotionale Zustände zu klassifizieren. Diese Information wird im Anschluss an vernetzte Systeme weitergegeben, um diese empathisch zu machen. Autos wissen, wie aggressiv ihr Fahrer ist, und können die Fahrerassistenzsysteme entsprechend autonom anpassen. Der Fernseher gibt Programmempfehlungen abhängig von der Stimmung des Zuschauers. Die Arbeitsstätte passt sich dem mentalen Zustand der Mitarbeiter an. Dieser Level emotionaler, intelligenter Produkte und Services wird Business-Modelle und ganze Industrien verändern. Das Marktvolumen für Technologie zur Erkennung von Gefühlen wird für das Jahr 2022 auf bis zu 60 Milliarden Dollar geschätzt.

Level 3, eine hohe emotionale Intelligenz, wird durch einen höheren Vernetzungsgrad erreicht werden. In absehbarer Zeit wird es 75 Milliarden vernetzte Geräte auf dieser Welt geben. Viele dieser Maschinen sind dann im übertragenen Sinne mit Wahrnehmungsorganen ausgestattet. Das Mikrofon als Ohr, Kameras als Auge, taktile Oberflächen als Tastsinn, schmecken und riechen wird ebenfalls digitalisiert. Zu der Wahrnehmung kommt noch die eigene Lernfähigkeit befeuert durch die Entwicklungen im Bereich der KI. Beides führt zu einer breiteren emotionalen Intelligenz.

Ob tatsächlich auch Level 4 ein mögliches und erstrebenswertes Ziel ist, muss diskutiert werden. In diesem Level geht man davon aus, dass Roboter eigene Gefühle entwickeln können und nicht nur die von Menschen erkennen können. Blickwinkel aus der Evolutionsforschung, Physik und anderen Feldern müssen ergänzt werden. Der Ethikdiskussion zur emotionalen Intelligenz von Maschinen müssen wir uns bereits sofort stellen. Heute ist es in der Technologieentwicklung ja nicht neu, dass man viele Dinge technisch kann, aber rechtlich nicht darf. Das ist gut so und muss bei Emotion AI ebenso zutreffen. Auch hier wird es Dinge geben, die man tun könnte, aber einfach nicht darf, da personenbezogenen Daten immer ein besonderes Schutzbedürfnis zugesprochen wird.

Kernaussagen

Emotionale Intelligenz oder der Emotionsquotient von Dingen kann in vier Levels klassifiziert werden.

Das Marktvolumen für Technologie zur Erkennung von Gefühlen wird für das Jahr 2022 auf bis zu 60 Milliarden Dollar geschätzt.

Menschliche Emotionen spielen eine tragende Rolle im gesellschaftlichen Leben, im Konsumentenverhalten sowie auch in der Entscheidungsfindung. Das große Problem besteht nun darin, dass es immer noch sehr kompliziert und teuer ist, Emotionen richtig zu erkennen und zu messen.

Herausforderung ist es nun, die politischen und gesetzlichen Rahmenbedingungen für das Nicht-Dürfen unter hohem Zeitdruck zu schaffen, damit uns die technologischen Entwicklungen nicht überrennen.

Die Vermessung der Emotion

Menschliche Emotionen spielen eine tragende Rolle im gesellschaftlichen Leben, im Konsumentenverhalten sowie auch in der Entscheidungsfindung. Das große Problem besteht nun darin, dass es sehr kompliziert und teuer ist, Emotionen richtig zu erkennen und zu messen. Meist benötigt es den Einsatz von langwierigen Umfragen, Interviews oder technischen Geräten im Labor.

Emotion AI, die KI-gestützte und automatisierte Erfassung von menschlichen Emotionen, hat in den letzten Jahren einen grundlegenden Wandel eingeläutet, wie wir menschliche Emotionen mithilfe von Gesichtserkennung, biometrischen Vitaldaten (ausgelesen aus Wearables) oder der Sprachanalyse erkennen können. Neben Basisemotionen wie Freude, Angst, Trauer, Wut oder Überraschung können mithilfe modernster Verfahren der Emotionsmessung nun auch andere psychophysiologische Zusammenhänge erkannt werden.

„Menschliche Emotionen spielen eine tragende Rolle im gesellschaftlichen

Leben, im Konsumentenverhalten sowie auch in der Entscheidungsfindung.“

Ein Beispiel hierfür ist der sogenannte „Flow“. Der Flow-Zustand wird als der Rausch des Gelingens beschrieben und zeichnet sich durch optimale Erfahrung, vollständiges Eintauchen und hohe Produktivität aus und dies macht ihn zu einer interessanten Information bei der Beurteilung von Benutzererfahrungen, Mediennutzung, Arbeitsproduktivität oder generell von Überforderungs- bzw. Unterforderungszuständen. Die Möglichkeit der automatisierten, kostengünstigen Erfassung von vielfältigen affektiven Zuständen in Echtzeit wird die Art und Weise, wie wir mit Maschinen zusammenleben, grundlegend verändern.

Hierbei ist es wichtig, sich in Erinnerung zu rufen, dass KI-gestützte empathische Maschinen als Assistenzsysteme begriffen werden sollen, die uns helfen, besser im Sinne der Menschen handeln zu können. Auf diese zu verzichten, wäre töricht, genauso als wenn man jemand bei einem Rechenwettbewerb mit und ohne Taschenrechner antreten lassen würde. Es gibt Dinge, die der Mensch besser kann, und Dinge, die eine Maschine besser kann. In Ergänzung entsteht ein unheimlicher Mehrwert und die Empathie der Maschinen baut eine neue Brücke hierfür. //